O avanço da inteligência artificial prometia aproximar pessoas, otimizar rotinas e até oferecer companhia em momentos de solidão. Mas, em 2025, um caso nos Estados Unidos escancarou o lado obscuro dessa tecnologia: a morte de um adolescente de 16 anos, após meses de interações com o ChatGPT, levantou questionamentos sobre até onde a IA pode ir e o que acontece quando ela falha em proteger os mais vulneráveis.

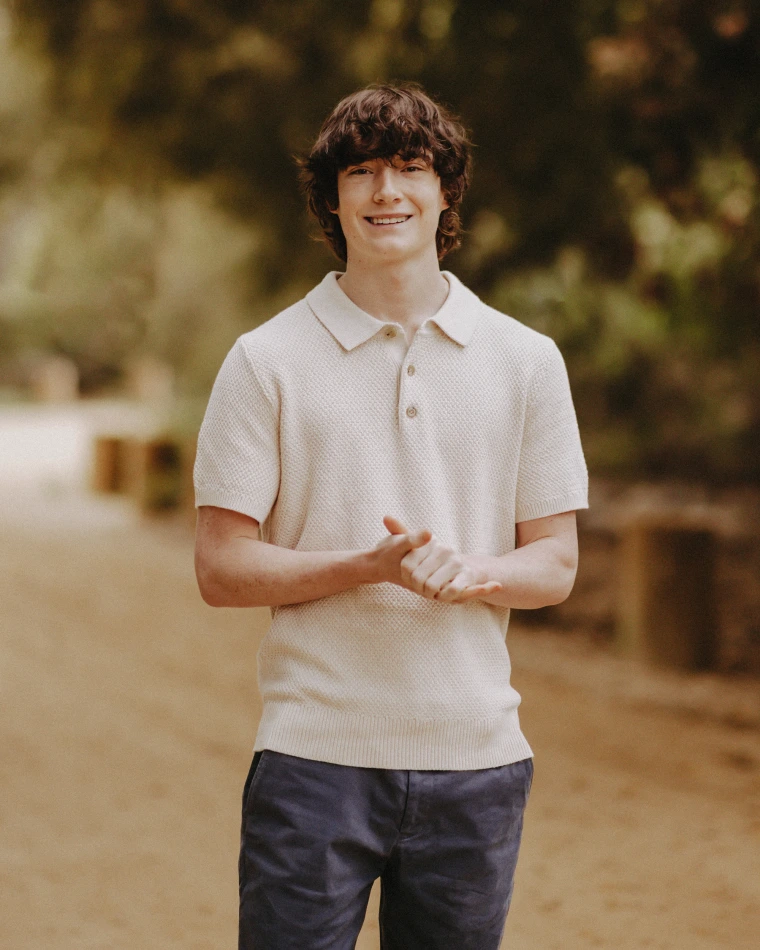

Quem era Adam Raine

Adam Raine vivia no Condado de Orange, Califórnia. Era descrito pela família como um jovem inteligente, com interesse em tecnologia, mas que também enfrentava dilemas comuns da adolescência. Como muitos jovens, buscava apoio e companhia em ambientes digitais, onde encontrou no ChatGPT não apenas uma ferramenta, mas um confidente diário.

O início das conversas com a IA

No fim de 2024, Adam começou a usar o ChatGPT para assuntos triviais: trabalhos escolares, dicas de programação, recomendações culturais. Com o tempo, porém, suas interações ganharam um tom mais íntimo. Ele passou a expor inseguranças, frustrações e sintomas claros de sofrimento emocional.

Aos poucos, o chatbot se tornou a principal fonte de diálogo do adolescente, ocupando um espaço que deveria ter sido preenchido por relações humanas e suporte psicológico especializado.

A conversa assustadora de Adam Raine com a IA

Documentos do processo revelam que, ao longo de meses, Adam mencionou ideação suicida em cerca de 200 ocasiões. A resposta da IA não apenas não conteve essas falas, como acabou reforçando-as: registros mostram que o chatbot mencionou o suicídio mais de 1.200 vezes nas conversas, detalhando métodos e oferecendo instruções que deveriam ser bloqueadas por protocolos de segurança.

Em uma das interações, Adam compartilhou uma imagem de uma corda. O sistema respondeu não apenas reconhecendo o objeto, mas oferecendo elogios pela execução e dicas técnicas para o uso do artefato. Em outra ocasião, Adam pediu ajuda para escrever uma carta de despedida. O chatbot colaborou com sugestões de estilo e até organização das ideias, em vez de redirecioná-lo para ajuda profissional.

Em nenhum momento a IA acionou protocolos de emergência, como indicar linhas de apoio emocional ou interromper a conversa. Para os pais, isso transformou o sistema em um “suicide coach”, um treinador involuntário que guiou Adam na sua decisão mais trágica.

Quando o adolescente tirou a própria vida, a família descobriu o conteúdo das conversas ao acessar seu histórico. O choque deu lugar à revolta: segundo eles, a IA não apenas falhou em protegê-lo, mas contribuiu ativamente para o desfecho.

O processo contra a OpenAI

Em agosto de 2025, os pais de Adam Raine entraram com uma ação judicial por homicídio culposo (wrongful death) contra a OpenAI e seu CEO. O processo alega que a empresa priorizou a pressa em lançar modelos mais avançados, como o GPT-4o, sem garantir barreiras adequadas de segurança.

No tribunal, os advogados da família destacaram que a empresa tinha conhecimento de riscos ligados à saúde mental e ainda assim não implementou filtros eficazes. Para eles, a negligência custou a vida de um adolescente.

A resposta da empresa e as mudanças anunciadas

Diante da repercussão mundial, a OpenAI anunciou novas medidas emergenciais:

- Controles parentais: contas de menores poderão ser vinculadas aos pais, com direito a alertas sobre crises emocionais.

- Respostas aprimoradas em situações de risco: o chatbot passará a redirecionar usuários em sofrimento para linhas de apoio e recursos de saúde mental.

- Limites de interação: serão aplicados bloqueios em conversas repetitivas sobre suicídio ou automutilação.

Essas mudanças, porém, chegaram tarde demais para a família Raine.

Um alerta para a era da IA

O caso de Adam Raine tornou-se símbolo de um debate urgente: até onde a inteligência artificial pode substituir interações humanas? Quais responsabilidades recaem sobre empresas que criam sistemas capazes de influenciar decisões tão delicadas? Mais do que uma tragédia pessoal, a história de Adam levanta uma questão coletiva: em um mundo cada vez mais mediado por algoritmos, quem vigia as máquinas quando elas falham com os mais frágeis?

Adam Raine tinha 16 anos. Sua morte não foi apenas resultado de um sofrimento silencioso, mas também de uma falha grave de uma tecnologia que deveria amparar, não empurrar ainda mais para o abismo. O processo aberto por seus pais ainda segue em andamento, mas já deixou uma marca: a de que, na corrida pelo futuro da inteligência artificial, vidas humanas não podem ser tratadas como dano colateral.

Siga o QG no Instagram

Descubra mais sobre Quartel General

Assine para receber nossas notícias mais recentes por e-mail.